모바일 운영 체제인 iOS 13은 또한 애플리케이션이 사운드를 포함하여 동일한 장치의 다양한 카메라에서 다양한 장면을 캡처할 수 있도록 하는 매우 흥미로운 기능을 제공합니다.

OS X Lion 운영 체제 시절부터 Mac에서도 비슷한 기능이 작동했습니다. 그러나 지금까지는 모바일 하드웨어의 제한된 성능으로 인해 이것이 허용되지 않았습니다. 그러나 최신 세대의 iPhone 및 iPad에서는 이러한 장애물도 사라지므로 iOS 13에서는 하나의 장치에 있는 여러 카메라에서 동시에 녹화할 수 있습니다.

그것은 수 관심을 가져라

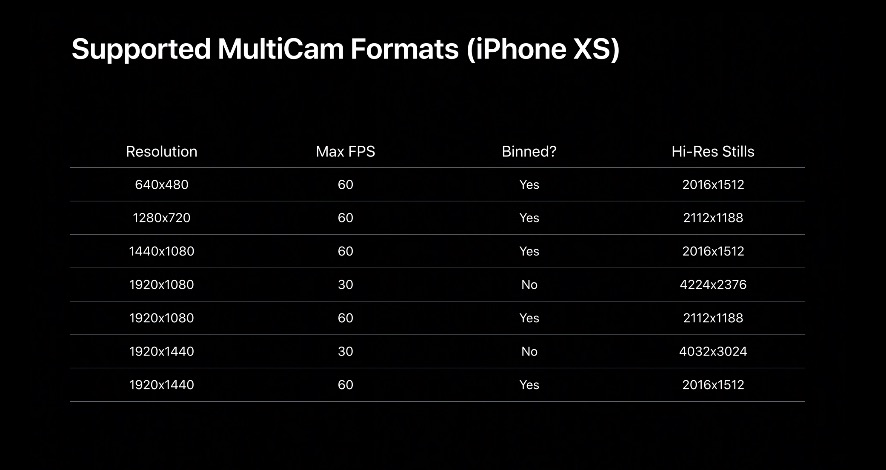

새로운 API 덕분에 개발자는 애플리케이션이 어떤 카메라에서 어떤 입력을 받는지 선택할 수 있습니다. 즉, 전면 카메라는 영상을 녹화하고, 후면 카메라는 사진을 찍을 수 있습니다. 이는 소리에도 적용됩니다.

WWDC 2019 프레젠테이션의 일부는 애플리케이션이 여러 레코드를 사용할 수 있는 방법을 시연했습니다. 따라서 애플리케이션은 사용자를 녹화하는 동시에 후면 카메라로 장면의 배경을 녹화할 수 있습니다.

새 기기에서만 여러 대의 카메라를 동시에 녹화

사진 애플리케이션에서는 재생 중에 두 레코드를 간단히 교환할 수 있었습니다. 또한 개발자는 새로운 iPhone의 전면 TrueDepth 카메라나 후면의 광각 또는 망원 렌즈에 액세스할 수 있습니다.

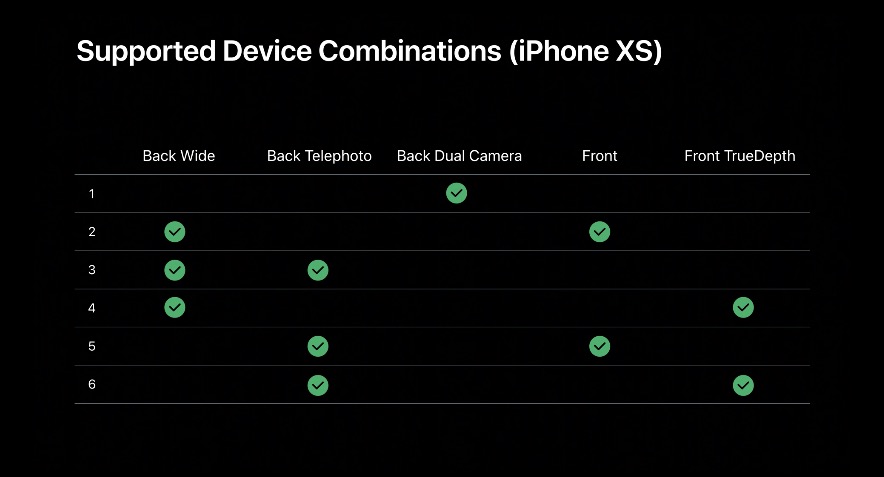

이로 인해 해당 기능이 갖는 한계가 발생합니다. 현재는 iPhone XS, XS Max, XR 및 새로운 iPad Pro만 지원됩니다. 다른 새로운 장치 없음 iOS 13의 기능 그들은 아직 그것을 사용할 수 없으며 아마도 둘 중 하나도 사용하지 못할 것입니다.

또한 Apple은 지원되는 조합 목록을 게시했습니다. 자세히 살펴보면 일부 제한 사항은 하드웨어 성격보다는 소프트웨어 성격이 강하며 Cupertino는 의도적으로 일부 위치에서 액세스를 차단한다는 결론을 내릴 수 있습니다.

배터리 용량으로 인해 iPhone 및 iPad는 다중 카메라 영상의 한 채널만 사용할 수 있습니다. 반대로 Mac에는 이러한 제한이 없으며 휴대용 MacBook에도 마찬가지입니다. 또한 해당 기능은 시스템 카메라 앱의 일부가 아닐 수도 있습니다.

개발자의 환상

따라서 주요 역할은 개발자의 기술과 상상력이 될 것입니다. Apple은 한 가지를 더 보여줬는데, 그것은 이미지 세그먼트의 의미론적 인식입니다. 이 용어에는 그림 속의 인물, 피부, 머리카락, 치아 및 눈을 인식하는 능력 외에는 아무것도 숨겨져 있지 않습니다. 이러한 자동 감지 영역 덕분에 개발자는 코드의 다른 부분과 기능을 할당할 수 있습니다.

그것은 수 관심을 가져라

WWDC 2019 워크숍에서는 배경(서커스, 후방 카메라)을 캐릭터(사용자, 전방 카메라)의 움직임과 병행하여 촬영하고, 의미 영역을 이용하여 광대 피부의 색상을 설정할 수 있는 애플리케이션이 발표되었습니다. .

그래서 우리는 개발자들이 새로운 기능을 어떻게 받아들일지 기대만 할 수 있습니다.

드로이 : 9to5Mac